- 品牌

- 荟安

- 型号

- 齐全

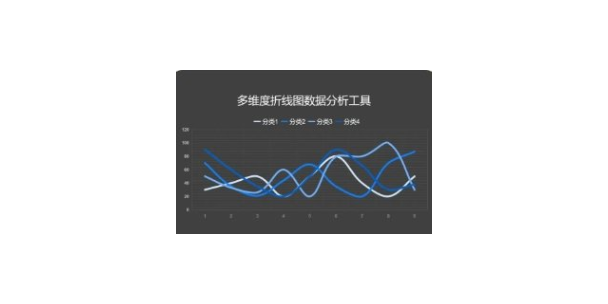

数据流分析是一项编译时使用的技术,它能从程序代码中收集程序的语义信息,并通过代数的方法在编译时确定变量的定义和使用。通过数据流分析,可以不必实际运行程序就能够发现程序运行时的行为,这样可以帮助大家理解程序。数据流分析被用于解决编译优化、程序验证、调试、测试、并行、向量化和片行编程环境等问题。控制流图理解数据流分析的一个预备概念是控制流图(control flow graph,简称CFG),简而言之就是流图。CFG是一个有向图,它包含一部分程序的控制流。CFG典型的应用是 类似过程大小的程序片断。 [1]典型的流图结点是基本块(总是顺序执行的代码片断),流图的边 基本块之间可能存在的控制流,其中的一个结点被标明为开始。企业文化是专业诚信眼睛。黄浦区品牌数据分析工具

初获得的数据必须经过处理或组织以供分析。 例如,这些可能涉及将数据放入表格格式(称为结构化数据)的行和列中以供进一步分析,通常是通过使用电子表格或统计软件。处理和组织后,数据可能不完整、包含重复项或包含错误。 数据清理的需要将源于数据输入和存储方式的问题。 数据清洗就是防止和纠正这些错误的过程。常见任务包括记录匹配、识别数据的不准确性、现有数据的整体质量、重复数据删除和列分割。 此类数据问题也可以通过各种分析技术来识别。 例如; 对于财务信息,可以将特定变量的总数与被认为可靠的单独发布的数字进行比较。 也可能会审查高于或低于预定阈值的异常数量。 有几种类型的数据清理,这取决于集 中的数据类型; 这可能是电话号码、电子邮件地址、雇主或其他值。 用于离群值检测的定量数据方法可用于去除似乎输入错误的可能性更高的数据。 文本数据拼写检查器可用于减少打错字的数量。 然而,很难判断这些词本身是否正确。奉贤区科技数据分析工具目前数据分析的工具有哪些。

在统计学领域,有些人将数据分析划分为描述性统计分析、探索性数据分析以及验证性数据分析;其中,探索性数据分析侧重于在数据之中发现新的特征,而验证性数据分析则侧重于已有假设的证实或证伪。 [1]探索性数据分析探索性数据分析是指为了形成值得假设的检验而对数据进行分析的一种方法,是对传统统计学假设检验手段的补充。该方法由美国 统计学家约翰·图基(John Tukey)命名。 [1]定性数据分析定性数据分析又称为“定性资料分析”、“定性研究”或者“质性研究资料分析”,是指对诸如词语、照片、观察结果之类的非数值型数据(或者说资料)的分析。

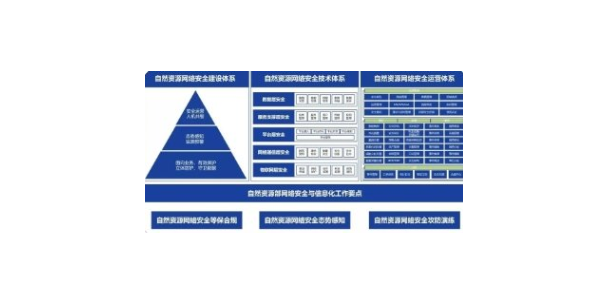

Stata的统计功能很强,除了传统的统计分析方法外,还收集了近20年发展起来的新方法,如Cox比例风险回归,指数与Weibull回归,多类结果与有序结果的logistic回归,Poisson回归,负二项回归及广义负二项回归,随机效应模型等。具体说, Stata具有如下统计分析能力:数值变量资料的一般分析:参数估计,t检验,单因素和多因素的方差分析,协方差分析,交互效应模型,平衡和非平衡设计,嵌套设计,随机效应,多个均数的两两比较,缺项数据的处理,方差齐性检验,正态性检验,变量变换等。分类资料的一般分析:参数估计,列联表分析 ( 列联系数,确切概率 ) ,流行病学表格分析等。造成网络安全的主要因素有哪些。

生存分析(Survival analysis)Kaplan–Meier、Nelson–Aalen、Cox回归(弱性)、参数模式(弱性)、危险比例测试、时间共变项、左-右检查、韦柏分配、指数分配…流行病学工具(Tools for epidemiologists)比例标准化、病例控制、已配适病例控制、Mantel – Haenszel,药理学、ROC分析、ICD-9-CM时间序列(Time series)ARIMA、ARCH/GARCH、VAR、Newey–West、correlograms、periodograms、白色 - 噪音测试、 小整数根检定、时间序列运算、平滑化 大概似法(Maximum likelihood)转换及常态检定(Transforms and normality tests)Box–Cox、次方转换Shapiro–Wilk、Shapiro–Francia检定其它统计方法(Other statistical methods)样本数量及次方、非线性回归、逐步式回归 、统计及数学函数包含样本范例(Sample session)再抽样及模拟方法(Resampling and simulation methods)bootstrapping、jackknife、蒙地卡罗模拟、排列检定网络功能安装新指令、网络升级、网站档案分享、Stata 新消息epiman论坛学习资源丰富,学术氛围良好,在国内新生代公共卫生学术界有一定影响力。是探讨Stata、spss、sas、epidata等统计软件的主流论坛之一。该企业的目标是努力成为上市公司。工程数据分析工具管理模式

有机会去贵司参观学习。黄浦区品牌数据分析工具

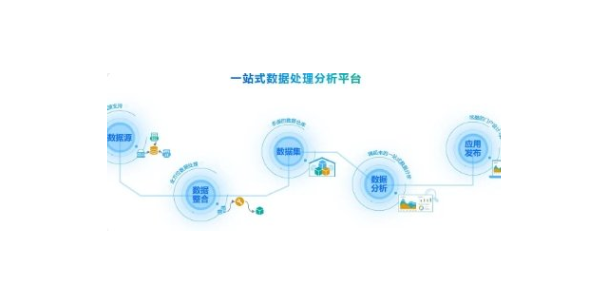

数据分析过程的主要活动由识别信息需求、收集数据、分析数据、评价并改进数据分析的有效性组成。 [6]识别需求识别信息需求是确保数据分析过程有效性的首要条件,可以为收集数据、分析数据提供清晰的目标。识别信息需求是管理者的职责管理者应根据决策和过程控制的需求,提出对信息的需求。就过程控制而言,管理者应识别需求要利用那些信息支持评审过程输入、过程输出、资源配置的合理性、过程活动的优化方案和过程异常变异的发现。。黄浦区品牌数据分析工具

上海荟安信息技术有限公司在同行业领域中,一直处在一个不断锐意进取,不断制造创新的市场高度,多年以来致力于发展富有创新价值理念的产品标准,在上海市等地区的数码、电脑中始终保持良好的商业口碑,成绩让我们喜悦,但不会让我们止步,残酷的市场磨炼了我们坚强不屈的意志,和谐温馨的工作环境,富有营养的公司土壤滋养着我们不断开拓创新,勇于进取的无限潜力,上海荟安信息技术供应携手大家一起走向共同辉煌的未来,回首过去,我们不会因为取得了一点点成绩而沾沾自喜,相反的是面对竞争越来越激烈的市场氛围,我们更要明确自己的不足,做好迎接新挑战的准备,要不畏困难,激流勇进,以一个更崭新的精神面貌迎接大家,共同走向辉煌回来!

1、沃尔玛经典营销案例:啤酒与尿布“啤酒与尿布”的故事产生于20世纪90年代的美国沃尔玛超市中,沃尔玛的超市管理人员分析 时发现了一个令人难于理解的现象:在某些特定的情况下,“啤酒”与“尿布”两件看上去毫无关系的商品会经常出现同一个购物篮中,这种独特的销售现象引起了管理人员的注意,经过后续调查发现,这种现象出现年轻的父亲身上。 [7]在美国有婴儿的家庭中,一般是母亲在家中照看婴儿,年轻的父亲前去超市购买尿布。公司的福利待遇很不错的。上城区出口数据分析工具有其他证据佐证并以合法手段取得的、无疑点的视听资料或者与视听资料核对无误的复制件”。 [1]合法性原则违反法定程序取得的证据应予以排除。我国《...

- 富阳区机械数据分析工具 2024-12-28

- 浙江哪里数据分析工具 2024-12-28

- 吉林哪里数据分析工具 2024-12-28

- 闵行区工程数据分析工具 2024-12-28

- 上海工程数据分析工具 2024-12-27

- 山西进口数据分析工具 2024-12-27

- 松江区进口数据分析工具 2024-12-27

- 余杭区机电数据分析工具 2024-12-27

- 北京多功能数据分析工具 2024-12-27

- 桐庐多功能数据分析工具 2024-12-27

- 科技数据分析工具一体化 2024-12-25

- 宁波什么是数据分析工具 2024-12-25

- 北京机械数据分析工具 2024-12-25

- 重庆新能源数据分析工具 2024-12-25

- 西湖区机电数据分析工具 2024-12-25

- 奉贤区新能源数据分析工具 2024-12-25

- 吉林哪里数据分析工具 12-28

- 静安区多功能网络安全解决方案 12-28

- 杨浦区机电网络安全解决方案 12-28

- 崇明区科技网络安全解决方案 12-28

- 机电网络安全解决方案管理模式 12-28

- 闵行区工程数据分析工具 12-28

- 浦口区机电网络安全解决方案 12-27

- 上海工程数据分析工具 12-27

- 山西进口数据分析工具 12-27

- 松江区进口数据分析工具 12-27